در جهانی که آن را هوش مصنوعی شکل داده است، رهبری انسان بیش از هر زمانی حیاتی است.

هوش مصنوعی، تکنولوژی های نوین، مدل های مبتنی بر هوش مصنوعی، خطرات هوش مصنوعی، رهبری انسانی

بدانیم یا ندانیم، تقریباً برای هر کسی پیشآمده که دران لحظه فهمیده باشد تا چه اندازهای به هوش مصنوعی وابسته است. این تجربه اغلب در صندلی عقبی ماشین به انسان دست میدهد. چند ماه پیش در صندلی عقب یک خودروی اشتراکی از اسکارسدیل[۱] که حومه نیویورک است به شهر نیویورک میآمدم. راننده بهتازگی از نپال مهاجرت کرده بود و توانایی وی در یافتن سریع مسیر بهخوبی نشان میداد که چگونه پلت فرمهای اشتراک خودرو موقعیتهای اقتصادی را باز میکنند. یک زمانی، راننده من قبل از رساندن مشتری از جایی بهجای دیگر مجبور بود منطقه را بهخوبی بشناسد. حال نقشهخوان هوش مصنوعی باعث شده که یک نفر که تازه به نیویورک رسیده بهراحتی کار کند.

منطقه کلانشهری شهر نیویورک یکی از پیچیدهترین مناطق در جهان است و راننده من حتی با نقشه به مشکل برمیخورد. بعد از چند مانور غیرقانونی و ایستادن بدون برنامه برای بنزین، من را به مقصدم رساند، اما همینکه داشتم پیاده میشدم فکر میکردم که موقعیت آن را داشتم که حتی راننده بسیار ماهرتری نصیبم شود.

بانفوذ بیشتر هوش مصنوعی در تجربیات و سازمانهای ما، نهتنها تشخیص بسیاری از مزایای آن مهم است، بلکه پیامدهای ناخواسته آن را نیز باید تشخیص داد. هوش مصنوعی ما را از خطرات ناشناخته حفظ میکند، به ما کمک میکند به افراد دیگر متصل شویم و پاسخهای بهتر را سریعتر و ارزانتر از پاسخهای انسانها فراهم میکند. البته، اینکه هوش مصنوعی ما را از وظایف روزانه مانند خواندن یک نقشه آزاد میکند بسیار عالی است؛ اما آیا به از دست دادن تخصص انسانی همراه با این آزادی جدید را درک میکنیم و به آن توجه داریم؟

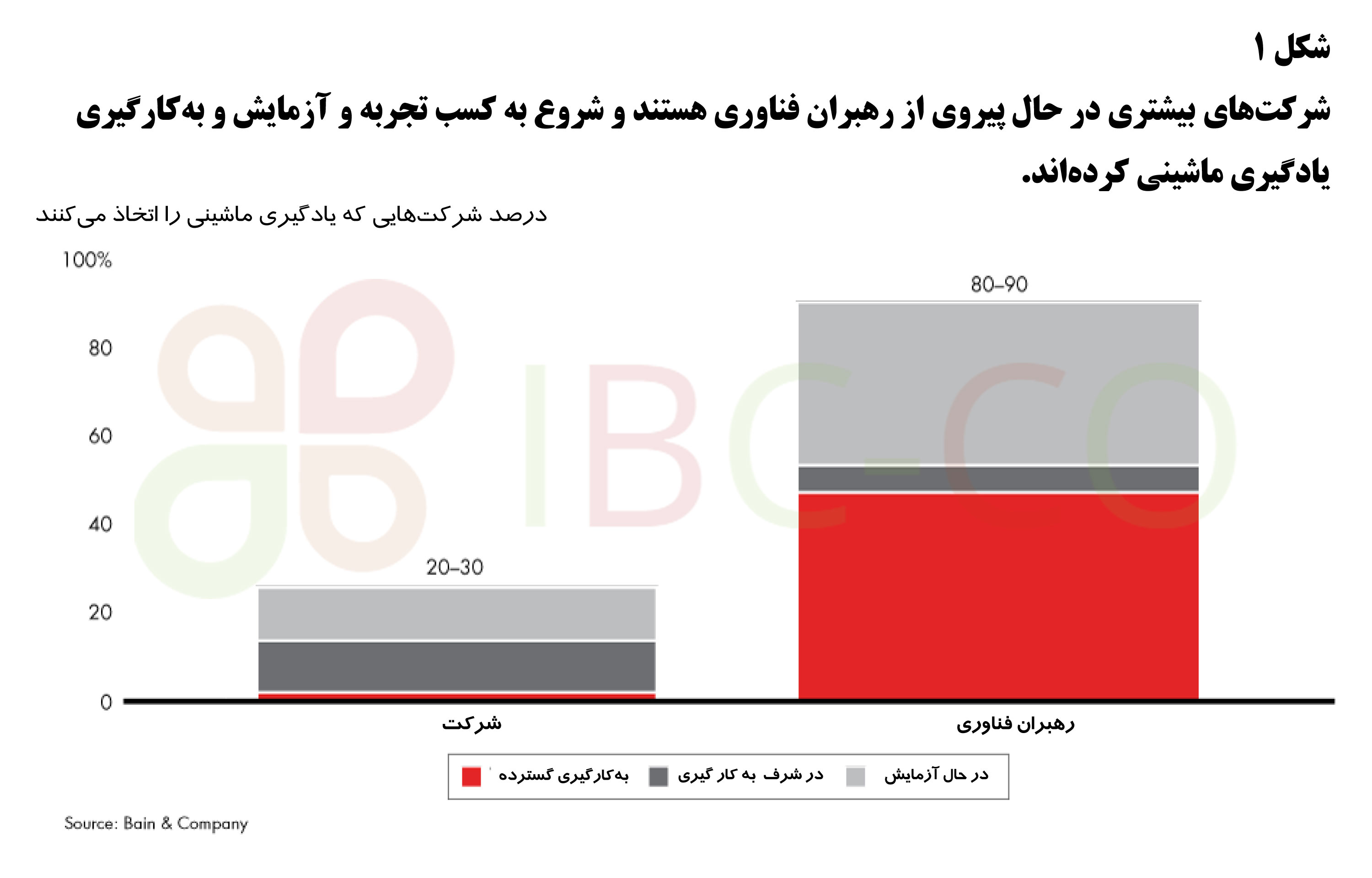

برای رهبران کسبوکارها و دیگر افرادی که در فناوری سرمایهگذاری میکنند، سؤالات مهمی وجود دارند که به آنها کمک میکند تا شروع به درگیر شدن با مفهوم رهبری در عصر هوش مصنوعی کنند – این سؤالات شامل چگونگی مدیریت خطرات و خواص منحصربهفرد هوش مصنوعی، ایجاد شفافیت و تمرکز بر گسترش آن و درنهایت ساختن برنامههای کاربردی بهتر از قِبلِ آن (شکل ۱).

همچنین ۶ خطر وجود دارد که باید در مباحثات جایداده شوند.

برخلاف قوانین سنتی مبتنی بر برنامهریزی، مدلهای هوش مصنوعی نمایشهای آماری جهان هستند. پاسخهایی مبتنی بر یادگیریِ خود را فراهم میکنند، اما کامل نیستند. ابهام بیشتر مدلهای هوش مصنوعی و تواناییشان در مقیاس سازی سریع باعث میشود برخی خطاها از دید آنها پنهان بماند. با رباتهای چت که در رسانههای اجتماعی به طور افسارگسیختهای حضور دارند، آشنا هستیم که دیدگاههای تبعیضآمیز را از مجموعه دادههای خود حذف میکنند چون بهنوعی در نمایش عموم است؛ اما سیستمهای مستقل رانندگی یا پرواز چطور؟ دادههای آموزشی آنها بهصورت نمایی در حال رشد است و مدلهای مبتنی بر آن بهصورت چشمگیری در حال ارتقا است، اما خطاهای الگوریتمها همچنان کشف میشوند و برخی اوقات پس از یک واقعه که منجر به از دست رفتن زندگی میشود این خطاها کشف میشوند.

تنها رانندگان خودروهای اشتراکی نیستند که درخطر وابستگی کامل به هوش مصنوعی قرار دارند. یک مهندس از سیلیکون ولی اخیراً بیان کرد که الگوریتم مورداستفادهشان به نحوی است که تیمش مجبور نیست زیاد فکر کند. چه دپارتمان مالی شرکتی که بهپیشبینیهای فروش الگوریتمی وابسته است و چه شما که فروشندهای هستید که از کس دیگری دستور میگیرد، درهرحال از دست دادن نوع درکِ اساس کسبوکار خود و چیزی که بهدرستی منجر به تقاضا میشود، خطرناک است.

الگوریتمها هم شبیه بشر در معرض دستکاری هستند. درحالیکه که یک کارگر تحت نظارت مدیریت است و در مسیر روزانه خود تصمیماتی اتخاذ میکند، اما الگوریتم تصمیمات فراوانی میگیرد که اغلب پنهان هستند. انتشاردهندگان هرزنامهها خیلی وقت پیش یاد گرفتند که چگونه از سیستمهای فراگیری ماشینی بهترین استفاده را بکنند و تمام دلایل مبنی بر این است که باور کنیم این هکرها کار خود را با هوش مصنوعی شروع کردند. به دستکاری در فصول انتخاباتی توسط رسانههای اجتماعی یا صنعت بهینهسازی موتور جستجو نگاه کنید. میتوان از الگوریتمها بهرهبرداری کرد. وسیعتر شدن نقش الگوریتمها – تعیین قیمت در یک سایت تجارت الکترونیک، تعیین نرخ بیمه اتومبیل، استخدام یک شخص – منجر به افزایش نگرانیها میشود. حال مدیران باید پیشبینی کنند که یک الگوریتم چگونه ممکن است دستکاری شده و سپس تنظیم شود.

اکثر ماشینهای هوش مصنوعی بامطالعه نمونهها در مجموعه دادههای طبقهبندیشده یاد میگیرند. متخصصان هوش مصنوعی ممکن است درک کنند که یک الگوریتم چگونه به نتیجهگیری میرسد یا شاید یک جعبه سیاه است که حتی برای متخصصان مرموز است. کمبود شفافیت، نگرانیها در مورد سوگیری را افزایش میدهد، زیرا هر الگوریتمی که بر روی دادههای تاریخی آموزش دادهشده است به این نتیجه خواهد رسید که سوگیری را در داده نشان دهد. بهعنوانمثال در صنعت رهن مسکن رهبران باید مطمئن شوند که الگوریتمهایشان با مقرراتی مطابق هستند که به دلیل خصوصیاتی مانند نژاد و جنسیت منجر به تبعیض نخواهند شد. تعصب نباید به دلیل منجر شدن به نتایج بد، غلط نمایان شود. بهعنوانمثال، در تجزیهوتحلیلهای مشتری، الگوریتمی که برحسب پایگاه دادههای مشتری موجود آموزش داده میشود، به اولویتهای مشتری توجه خواهد کرد؛ اما در مورد سلیقه بسیاری از مردم که هنوز نیازهایشان تأمین نشده است چطور؟ با الگوریتمهایی که حال در همهچیز از استخدام گرفته تا تحویل خدمات اجتماعی به نیازمندان، یک ریسک واقعی، تکرار چیزهایی که همیشه انجامشدهاند است.

با استفاده هر چه بیشتر شرکتها از رباتهای چت و دیگر مکانیسمها برای تعامل با مشتریان، سازمانها در معرض ریسک قطع ارتباط با مشتریانشان قرار میگیرند. برای مدیران، نگرانیهای کارگرانی که توسط الگوریتمها مدیریت میشوند، همانند رانندگان خودروهای اشتراکی امروزه، ممکن است احساس دوری کنند. فاصله میتواند همدردی مدیران و توانایی آنها برای گوش دادن به هر گروه را کاهش دهد، اما الزاماً مجبور نیست اینطور باشد. به دلیل اینکه من اغلب برای کار پرواز میکنم، در پنج ماه اخیر تنها یک پرواز از ویرجین آتلانتیک داشتهام و همان یک پرواز ۴۵ دقیقه تأخیر داشت. وقتی هواپیما فرود آمد، سیستمهای هواپیمایی مشکل را شناسایی کرده، ایمیلی حاوی متن عذرخواهی و یک کوپن تخفیفی برای پرواز دیگر به من ارسال کردند. بهجای اینکه تجربه تأخیر باعث عصبانیت من شود، بیشتر من را تحت تأثیر قرار داد.

تناسب و سرعت تصمیمگیریهای هوش مصنوعی بسیار جذاب است؛ اما باید گاهی اوقات بشر نیز مشارکت داشته باشد. هیچ مثال واضحتری از نقش یکپارچه که هواپیماهای بدون سرنشین در بمباران از راه دور اهداف جنگی دارند وجود ندارد. امروزه، پذیرفتهشده است که قضاوت انسانی باید مشارکت داشته باشد، اما هرچه به این فناوری عادت میکنیم، ممکن است که تغییر کند. آیا خوب خواهد بود؟ بسیاری از این قبیل سؤالات سخت در حوزه فرسایش کنترل انسانی توسط هوش مصنوعی وجود دارند. رهبران باید با اینگونه سؤالات درگیر شوند.

حاکمیت مهم است. مدیران ارشد باید در سازماندهی اهداف و محافظت هوش مصنوعی که بر کسبوکارشان تأثیر فراوانی دارد مشارکت کنند. در طول دههها، از سازمانهای خدمات مالی که بهشدت به الگوریتمهای اعتباری وابسته هستند انتظار میرود مدیریت ریسک را به طور قوی حکمرانی کنند؛ افزایش مشابه در حوزه مدیریت هوش مصنوعی ممکن است اکنون برای سازمانهایی لازم باشد که فناوری را به طور گستردهای در کسبوکارشان جاسازی میکنند.

حتی الگوریتمهایی که ازلحاظ مادی در کسبوکار مهم هستند نیز باید مدیر محصول داشته باشند – کسی که الگوریتم را آزمایش و بازنگری میکند، نتایج را حسابرسی میکند و عملکرد را ارزیابی و بهبود میبخشد.

سیستمهای قوی شنوایی انسانی ضروری هستند. از اجزای کلیدی یک الگوریتم مهم باید به طور منظم درخواست ورودی و بازخورد کرد، حال این اجزاء مشتری، کارکنان یا دیگر شرکا باشند. همدلی باید مدیریت و گسترش هر الگوریتمی را هدایت کند. سازمان باید قادر باشد زمانی که یک تنظیم مجدد ضروری است را شناسایی کند.

اینکه این مسئله چگونه برای سازمان نقش ایفا میکند، به صنعت و زمینه بستگی دارد. هرکدام موقعیتهای هوش مصنوعی و مشکلات احتمالی خاص خود رادارند. بااینوجود، سؤالات مشخصی وجود دارند که به هر مدیر یا عضو هیئتمدیره کمک میکنند که گفتار صحیح در اطراف هوش مصنوعی را استفاده کنند:

فراگیر بودن و مقیاسپذیری هوش مصنوعی بدین معنی است که الگوریتمها میتوانند میلیونها انسان را تحت تأثیر قرار دهند. لازمه رقابت و پیشرفت استفاده از هوش مصنوعی است، اما فناوری نه الزاماً اخلاقی است و نه ذاتاً همیشه در راستای بهبود است. این مسئله به افرادی بستگی دارد که از آن استفاده میکنند. در جهانی که هوش مصنوعی آن را شکل داده است، رهبری انسان پیش از همیشه ضروری است.

[۱] – Scarsdale

ما گروهی از مدیران و متخصصان مدیریت، مهندسی، استراتژی و بازاریابی با تجربه بین المللی هستیم که در پی ارتقای سطح دانش کاربردی مدیریت در پهنه صنعت و تجارت کشوریم. در این راه آماده ارایه خدمات در شاخه های کسب وکار گوناگون و صنایع مختلف هستیم.

آدرس: تهران، دهکده المپیک، دانشگاه علامه طباطبایی، دانشکده مدیریت و حسابداری

شماره تماس: ۰۹۱۹۸۳۶۶۳۶۱

ایمیل: Ibc.consulting2020@gmail.com

استفاده از مطالب با ذکر منبع بلامانع است.